In meinem vorherigen Posting habe ich beschrieben was der Unterschied zwischen Google-Filter und Google-Penalty ist. Diesen Beitrag behandelt den Google-Filter. Insbesondere was man machen kann, um den Filter zu vermeiden bzw. wie man aus dem Filter wieder heraus kommt.

Inhalt:

- 1. Google-Filter für neue Domains

- 2. Google-Filter aufgrund externer Verlinkung

- 3. Google-Filter aufgrund von Onpage-Faktoren

- 4. Fazit zu Google-Filtern

1. Google-Filter für neue Domains

Besonders mit neuen Domains rutscht man schnell in den sogenannten „Domain Name Age“-Filter. Zu Beginn kann Google eine frische Domain nicht immer einstufen. Erst wenn ein Vertrauen aufgebaut wird, rankt die Webseite auch wieder besser. Hier habe ich ein Einpendeln festgestellt (Sprünge im Ranking).

Was hilft?

- Kontinuierlich neue Links

- Backlinks von vertrauenswürdigen Webseiten

- Langsames Wachstum

2. Google-Filter aufgrund externer Verlinkung

Stetiges Wachstum ist wichtig für jede Webseite. Allerdings gibt es einige Dinge, die von Google negativ eingestuft werden.

2.1 Google-Bombing – viele Links mit gleichen Anchor-Texten

Wer in kurzer Zeit viele Backlinks mit gleichen Anchor-Text erhält, fällt in das Auge von Google. Hier greift ein automatischer Filter. Auch ist es eine Penalty möglich. Meistens deutet die Linksetzung mit gleichen Anchor darauf hin, dass Links getauscht, gekauft oder gemietet wurden. Mal davon abgesehen verfechten nicht alle die These, dass Keyword-Links so mächtig sind.

Was hilft?

- Auf keinen Fall bestehende Links löschen oder abändern (Risiko Linkabbau).

- Stattdessen lieber neue Links mit variierenden Anchor-Texten setzen.

2.2 Bad Neighborhood – schlechte Nachbarschaft Filter

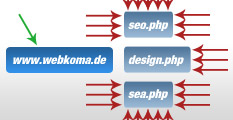

Gerade am Anfang ist es wichtig gute Backlinks von vertrauenswürdigen Webseiten zu erhalten. Wer stattdessen von Webseiten Links erhält, die auch auf Seiten linken, die gegen die Google Webmaster Richtlinien verstoßen, kann unter Umständen von Google auch schlecht eingestuft werden. Gleiches gilt auch für externe Links von der eigenen Domain. Wer auf komische Webseiten verlinkt braucht sich nicht wundern, wenn Google die eigene Domain ebenfalls zur „schlechten Nachbarschaft“ zählt.

Was hilft?

- Backlinks von schlechten Webseiten vermeiden

- Aufpassen worauf man linkt

- „Schlechte Links“ entfernen

2.3 Zu schneller/ungewöhnlicher Linkwachstum

Wenn eine Domain plötzlich viele Backlinks erhält und dann auf einmal keine/kaum Backlinks erhält, dann liegt die Vermutung nicht weit, dass hier unnatürlich nachgeholfen wurde.

Was hilft?

- Regelmäßiger Backlink-Aufbau mit leichten Ausschlägen ist gut.

- Auf keinen Fall bestehende Backlinks entfernen (lassen).

- Weiter Backlinks sammeln (natürlich und in gesundem Maße)

2.4 Ungewöhnliches Verhältnis zwischen Startseiten- und Deeplinks

Die sogenannte Deeplink-Ratio ist ein Filter in dem viele Webseiten landen bei denen das Verhältnis nicht passt. Es werden z.B. durch Webkatalog-Einträge zu viele Links auf die Startseite gesetzt oder durch Social Bookmarking zu viele Links auf Unterseiten gesetzt.

Doch wie sieht die optimale Deeplink-Ratio aus? Hier ist zu unterscheiden zwischen den Webseiten-Typen. Blogs haben z.B. naturgemäß mehr Unterseiten-Verlinkungen (meinen Erfahrungen nach sollten es mindestens 60% Unterseiten-Links sein). Lokale Unternehmen werden meistens zur Startseite verlinkt (oft >80%). News-Portale haben nur 10% bis 30% an Startseiten-Links. Ein guter Beitrag zum Thema „Anteil Backlinks Startseite und Unterseiten – Deeplink-Ratio als Qualitätssignal“ ist auf SEO-Strategie.de zu lesen.

Was hilft?

- Je nach Seitentyp auf passende Deeplink-Ratio achten

- Speziell Backlinks aufbauen für ein passendes Verhältnis

2.5 Ungewöhnliches Linkbild (PR-Verteilung)

Erst am 20.Januar 2011 hatte Google nach langer Zeit wieder ein PageRank-Update gemacht. Damit ist der PR immer noch für die schnelle Bewertung der Wertigkeit einer Domain gültig. Aktuelle SEO-Tools stellen den PageRank auch heute noch da. Bei der externen Verlinkung der eigenen Domain sollte eine gesunde Verteilung herrschen. Dabei wird eine Domain hauptsächlich von Seiten verlinkt, die keinen PageRank haben (PR N/A).

Sistrix gibt folgende durchschnittliche PR-Verteilung aus:

- PR 9: 0%

- PR 8: 0%

- PR 7: 0,2%

- PR 6: 0,7%

- PR 5: 1,9%

- PR 4: 3,8%

- PR 3: 6,0%

- PR 2: 6,8%

- PR 1: 6,2%

- PR 0: 10%

- PR N/A: 64,6%

An den Durchschnittswerten würde ich nicht zu sehr festhalten. Bisher entspricht keine meiner Domains diesem Wert. Wer aber Ausreisser bei z.B. PR4-Links hat, macht auf sich aufmerksam und das könnte zu einem Filter führen. Besonders bei frischen Domains.

2.6 Google-Filter aufgrund einseitiger Verlinkung

Beim Linkbuilding sollte man nicht zu einseitig Links sammeln. Hier sollte man vermeiden eine lange Zeit lang nur Foren-Links zu sammeln, dann Social Bookmarks gefolgt von AV-Links. Ein gesunder Mix ist wichtig. Genaue Werte kann ich euch hier nicht liefern. Ich versuche das möglichst zu mixen.

3. Google-Filter aufgrund von Onpage-Faktoren

Technisch gesehen hat Google auch Qualitätsansprüche. Die sogenannten Onpage-Faktoren sollten daher auch beachtet werden.

3.1 Zu hohe Keyword-Dichte im Content, Title oder der Description

Mit dem „Google Florida“-Update ging es den Keyword-Stuffern an den Kragen. Wer heute die Texte nur für Suchmaschinen schreibt, kann schnell im Filter landen. Deshalb ist eine Keyworddichte von etwa 3% im Content sinnvoll (mehr zur Keyworddichte im Webmaster-Glossar). Das title-Attribut und die Meta-Angaben sollten für Menschen und nicht für Suchmaschinen geschrieben sein. Wobei nur noch der title auf das Ranking Einfluss zu haben scheint.

Was hilft?

- Texte abändern

- Title korrigieren

- Meta-Angaben anpassen (Description und Keywords)

3.2 Zu viele interne oder externe 404-Fehler

Wenn eine Webseite zu viele Links hat, die zu einer Fehlerseite führen, stuft Google die Webseite herunter. Macht auch Sinn – scheint sich der Webmaster doch nicht um seinen Inhalt zu kümmern. Deshalb sollte man regelmäßig die internen und externen Links prüfen.

Was hilft?

- Gebrochene Links entfernen (Für WordPress-Blogs habe ich in meinem Posting „WordPress-Plugins für den Start eines Blogs“ das Plugin Broken-Links vorgestellt. Zum direkten Prüfen bieten sich Xenu’s Link Sleuth (TM) für Windows und Integrity für Mac an.)

3.3 Google-Filter aufgrund von Duplicate Content

DC, ob bewusst oder unbewusst, ist Google ein Dorn im Auge. Unique Inhalte sind wichtig. Daher sollte man die eigene Webseite so gestalten, dass keine doppelten Inhalte vorliegen. Hierzu zähle ich auch die Gestaltung von title- und description-Attribute. Mit dem aktuellen „Google Farmer“-Update (seit 23.03.2011 via at-web.de), welches jetzt nur in den USA angewendet wird, geht es den Content-Farmen an den Kragen. Wer Inhalte von anderen Seiten kopiert, kann damit rechnen, dass in Zukunft die Webseite sehr viel schlechtere Rankings erzielt. Hier wird es sicherlich auch RSS-Seiten treffen.

Hierzu zählt aber auch interner DC. Hier sollte das Attribut „<meta name=“robots“ content=““ />“ im Head-Bereich sinnvoll gesetzt werden. Für startende WordPress-Blogs kann ich folgendes empfehlen:

Noindex für:

- Kategorien

- Tag-Seiten

- Archive

- Suchergebnisse auf der eigenen Seite

- Autor-Archiv

Nofollow für:

- Login- und Registrierungs-Links

- Affiliate-Links

- Werbe-Links und Werbe-Banner

4. Fazit zu Google-Filtern

Google-Filter sind eine ärgerliche Sache. Allerdings sollte man nicht verzweifeln und das Problem eingrenzen. Häufig ist man selbst daran Schuld auch wenn unbewusst optimiert wird. Ist der Fehler bzw. das Problem behoben, muss man nur noch darauf warten, dass Google dies bemerkt und die Webseite wieder ranken lässt. Das kann einige Tage oder auch Wochen dauern, sollte aber schon bald geschehen.

Falsch ist es wild irgendwelche Änderungen vorzunehmen. Dadurch kann man noch mehr kaputt machen. Besonders am Anfang ist Geduld gefragt. Ich weiß – auch für mich ist es manchmal schwierig mit Bedacht Links zu setzen oder auch von Trust-Webseiten aus den Content heraus mit „hier“ oder mit einem langen Satzteil zu verlinken. Aber oft wirken gerade diese Links sich auf die gesamte Domain und damit alle rankenden Keywords positiv aus.

Mich würden an dieser Stelle eure Meinungen interessieren. Könnt ihr meine Google-Filter ergänzen? Wie geht ihr vor?

Pingback: Backlinks setzen – Wie viele sind sinnvoll?

Noindex für:

* Kategorien

* Tag-Seiten

* Archive

* Suchergebnisse auf der eigenen Seite

* Autor-Archiv

Ich lasse immer die Kategorien übrig. Es besteht doch kein doppelter Content da ja nur der Text angeschnitten wird! Warum alles nofollow! Danke für die Antwort!

Hi Daniel,

gerade zu Beginn setze ich die Kategorien immer auf Nofollow. Tut man dies nicht, entsteht doppelter Inhalt vom feinsten. Des Weiteren sind in den Kategorie- und Tag-Seiten ein Großteil der Inhalte bereits auf anderen Seiten vorhanden. Da zählt Google dann meines Wissens auch die kurzen Ausschnitte als doppelten Inhalt.

Wenn du die Kategorie-Seiten indizieren lässt, dann versuche wenigstens mit Kategorie-Beschreibungen den Inhalt so unique wie möglich zu machen.

Das gleiche gilt auch für Tag-Seiten. Wenn eine gewisse Anzahl an Artikeln vorhanden ist und eine individuelle Beschreibung gemacht wird, dann können auch die Tag-Seiten nette Rankings erzielen.

Die Kategorie-Beschreibungen habe ich erstellt aber google webmaster tools meckert nun das zum Beispiel http://www.abcd-web.de/wordpress-plugins-test-tipps/ und http://www.abcd-web.de/wordpress-plugins-test-tipps/page/2/ das ich Doppelte Metabeschreibungen habe! Mit All in on Seo kann man das ja gar nicht umgehen oder? Ich habe gesehen das du das platinum seo pack nutzt kannman das dort einstellen?

Guter Artikel übrigens! Danke!

Danke :)

Nein leider kann das Platinum SEO Pack auch nicht. Allerdings gibt es in den Settings eine Option „Autogenerate Descriptions“, die ich aktiviert habe. Gilt scheinbar aber nur für Blog-Beiträge/Seiten, die keine von Hand gesetzte Description aufweisen.

Allerdings nutze ich in einigen Blogs auch WPSEO von Sergej Müller. Das erstellt auf jeder Kategorie-Seite eine individuelle Meta-Beschreibung voll automatisch anhand der Blog-Artikel-Titel, die sich auf der jeweiligen Seite befinden. Da wird das also besser gelöst. Muss ich mal überlegen, ob ich dahin migriere…

Das WpSeo zu kaufen überlege ich schon lange! Den Grund hätte man ja nun! :-)

Die Lizenz für einen Blog ist ja nicht so teuer. Hab diese auch erst vor einigen Wochen gekauft. 14 Tage kann man WPSEO übrigens soweit ich mich erinnere auch kostenlos testen. Beim Upgrade auf die Lizenz für eine unbegrenzte Anzahl an Blogs zahlt man dann auch nur den Differenz-Preis. Musst halt schauen, ob es sich lohnt. :-)

Lohnen tut sich das bestimmt, den durch doppelte Metabeschreibungen war mein Schwager mit seinen Unterseiten auf einmal sehr weit hinten in den Serp´s. Nach den Verändern der Metabeschreibungen ist er nun wieder normal gelistet. Ich denke deswegen schwören auch so viele WordPressblogger auf WpSeo!

Ob ein plötzlicher Backlinganstieg bei Google einen Filter verursacht, halte ich für ein Gerücht. Wenn Unternehmen neue Produkte vorstellen, stürzt sich die Presse darauf, und es hagelt nur so Backlinks. Das diese Seiten dadurch schaden nehmen, ist mir noch nie untergekommen.

Google erkennt dann sich auch diesen Unterschied. Allerdings ist die Regel, dass auch Abstrafungen durch zu viele Links eben nur kurzfristig wirken. Nerviger ist viel mehr dieser Newbie-Filter. Was doppelte Metas und Titel betrifft, gibts aber unterschiedliche Meinungen. Angeblich soll sogar Google diesen Punkt lediglich als Empfehlung anzeigen. Duplicate Content wird regulär lediglich im Content bestraft. Ansonsten wäre ja auch jede Kategorieleiste, welche sich sitewide erstreckt, doppelter Content … ;-)

„Google-Bombing – viele Links mit gleichen Anchor-Texten“ ….

Dann eignet sich demnach das Google-Bombing auch, um die Konkurrenz auszuschalten, oder?

Die blöde Konkurrenz wird immer vor mir mit meinen favorisierten Suchbegriff gefunden, also schnell mal 1000 Backlinks mit gleichen Anchor-Text gesetzt.

Puff weggefegt?? Wirklich?

So funktioniert Google. Ich bin nicht überzeugt. Eine Penalty möglich. Wo kann ich das nachlesen?

Dein Artikel ist echt toll erklärt. Mich hat es leider erwischt ich bin in dem Google Filter und selber schuld. Ich habe es mit dem Linktext übertrieben.

Aus Schaden wird man klug.

Gruß Mika

Wie erkennt man denn schlechte Links in schlechte Nachbarschaft?

Pingback: Auswirkungen von (zu viel) Affiliate-Werbung auf die Rankings

Wir haben einen Kunden gerade aus einer Penalty geholt. Erst erholten sich die Keywords von einen auf den anderen Tag. Genau am nächten erhielten wir in den Webmastertools von Google die Nachricht, dass die manuelle Spam Maßnahme von Google aufgehoben wurde. In den nächten Tagen erholte sich die Seite sehr langsam.

Wir begannen onpage einige wenige Änderungen vorzunehmen und stellten fest, dass nach jeder Änderung das Ranking einzelner Keywords extrem litt. Insbesondere als wir etwas an den Metadaten änderten. Jetzt sind die drei wichtigsten Kaywords aus dem Ranking geflogen. Als Longtail Suche in Kombination mit Anden Keywords rankt die Seite gut. Nur die drei wichtigsten Einzelkeyword ranken nicht mehr.

Hat jemand ähnliche Erfahrungen gemacht. hat jemand einen Tipp?